如何將工具輸出傳遞給聊天模型

先決條件

本指南假設您熟悉以下概念

有些模型能夠進行 工具呼叫 - 產生符合特定使用者提供架構的引數。本指南將示範如何使用這些工具呼叫來實際呼叫函式,並將結果正確傳遞回模型。

首先,讓我們定義我們的工具和模型

選擇聊天模型

pip install -qU "langchain[openai]"

import getpass

import os

if not os.environ.get("OPENAI_API_KEY"):

os.environ["OPENAI_API_KEY"] = getpass.getpass("Enter API key for OpenAI: ")

from langchain.chat_models import init_chat_model

llm = init_chat_model("gpt-4o-mini", model_provider="openai")

from langchain_core.tools import tool

@tool

def add(a: int, b: int) -> int:

"""Adds a and b."""

return a + b

@tool

def multiply(a: int, b: int) -> int:

"""Multiplies a and b."""

return a * b

tools = [add, multiply]

llm_with_tools = llm.bind_tools(tools)

API 參考:工具

現在,讓我們讓模型呼叫工具。我們會將其新增到訊息列表中,我們將其視為對話歷史記錄

from langchain_core.messages import HumanMessage

query = "What is 3 * 12? Also, what is 11 + 49?"

messages = [HumanMessage(query)]

ai_msg = llm_with_tools.invoke(messages)

print(ai_msg.tool_calls)

messages.append(ai_msg)

API 參考:HumanMessage

[{'name': 'multiply', 'args': {'a': 3, 'b': 12}, 'id': 'call_GPGPE943GORirhIAYnWv00rK', 'type': 'tool_call'}, {'name': 'add', 'args': {'a': 11, 'b': 49}, 'id': 'call_dm8o64ZrY3WFZHAvCh1bEJ6i', 'type': 'tool_call'}]

接下來,讓我們使用模型填充的引數來調用工具函式!

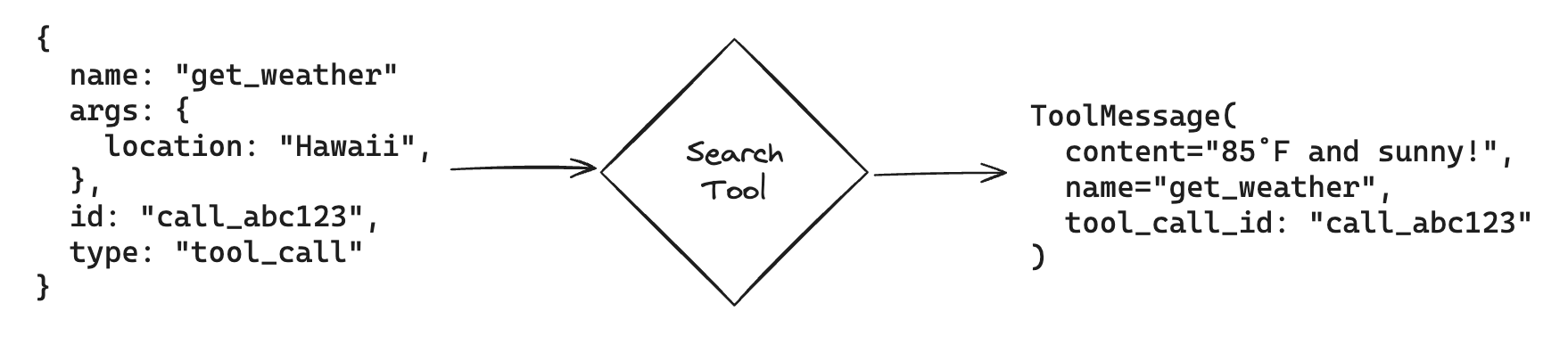

方便的是,如果我們使用 ToolCall 調用 LangChain Tool,我們將自動獲得可以回傳給模型的 ToolMessage

相容性

此功能已在 langchain-core == 0.2.19 中新增。請確保您的套件是最新的。

如果您使用的是較早版本的 langchain-core,則需要從工具中提取 args 欄位並手動建構 ToolMessage。

for tool_call in ai_msg.tool_calls:

selected_tool = {"add": add, "multiply": multiply}[tool_call["name"].lower()]

tool_msg = selected_tool.invoke(tool_call)

messages.append(tool_msg)

messages

[HumanMessage(content='What is 3 * 12? Also, what is 11 + 49?'),

AIMessage(content='', additional_kwargs={'tool_calls': [{'id': 'call_loT2pliJwJe3p7nkgXYF48A1', 'function': {'arguments': '{"a": 3, "b": 12}', 'name': 'multiply'}, 'type': 'function'}, {'id': 'call_bG9tYZCXOeYDZf3W46TceoV4', 'function': {'arguments': '{"a": 11, "b": 49}', 'name': 'add'}, 'type': 'function'}]}, response_metadata={'token_usage': {'completion_tokens': 50, 'prompt_tokens': 87, 'total_tokens': 137}, 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_661538dc1f', 'finish_reason': 'tool_calls', 'logprobs': None}, id='run-e3db3c46-bf9e-478e-abc1-dc9a264f4afe-0', tool_calls=[{'name': 'multiply', 'args': {'a': 3, 'b': 12}, 'id': 'call_loT2pliJwJe3p7nkgXYF48A1', 'type': 'tool_call'}, {'name': 'add', 'args': {'a': 11, 'b': 49}, 'id': 'call_bG9tYZCXOeYDZf3W46TceoV4', 'type': 'tool_call'}], usage_metadata={'input_tokens': 87, 'output_tokens': 50, 'total_tokens': 137}),

ToolMessage(content='36', name='multiply', tool_call_id='call_loT2pliJwJe3p7nkgXYF48A1'),

ToolMessage(content='60', name='add', tool_call_id='call_bG9tYZCXOeYDZf3W46TceoV4')]

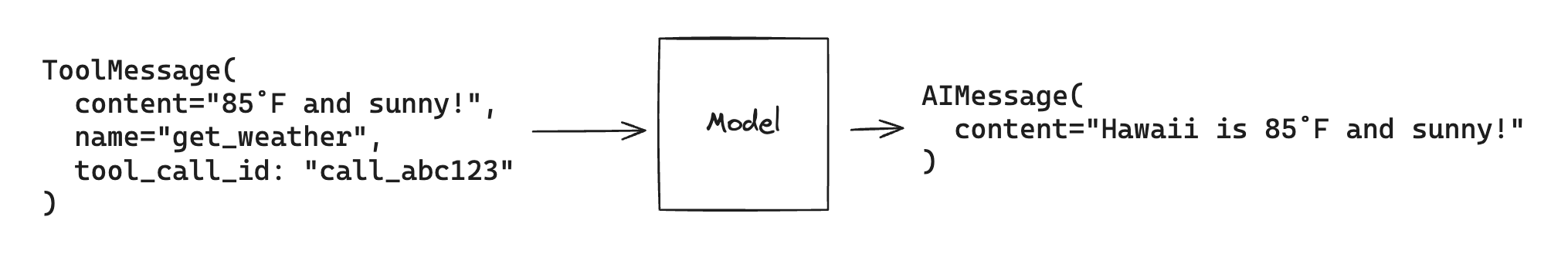

最後,我們將使用工具結果調用模型。模型將使用此資訊來產生對我們原始查詢的最終答案

llm_with_tools.invoke(messages)

AIMessage(content='The result of \\(3 \\times 12\\) is 36, and the result of \\(11 + 49\\) is 60.', response_metadata={'token_usage': {'completion_tokens': 31, 'prompt_tokens': 153, 'total_tokens': 184}, 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_661538dc1f', 'finish_reason': 'stop', 'logprobs': None}, id='run-87d1ef0a-1223-4bb3-9310-7b591789323d-0', usage_metadata={'input_tokens': 153, 'output_tokens': 31, 'total_tokens': 184})

請注意,每個 ToolMessage 都必須包含一個 tool_call_id,該 ID 與模型產生的原始工具呼叫中的 id 相符。這有助於模型將工具回應與工具呼叫匹配。

工具呼叫代理,例如 LangGraph 中的代理,使用此基本流程來回答查詢和解決任務。

相關連結

- LangGraph 快速入門

- 少量提示 搭配工具

- 串流 工具呼叫

- 將 執行階段值傳遞給工具

- 從模型取得結構化輸出